-

Vous êtes ici :

- Accueil

- Publications

Tous nos articles

Faire le lien entre tradition et innovation : le voyage d’un bibliothécaire avec Perplexity.ai

Ryan, qui a rejoint notre équipe de rédaction, est « Research librarian » à l’Université Wesleyan du Tennessee aux États-Unis. Cette fonction de « bibliothécaire spécialisé en recherche », située à l’intersection de la documentation et du soutien à la recherche académique joue un rôle très important dans la diffusion des connaissances et le développement des compétences en recherche au sein de l’université.

Les contributions de Ryan sont traduites de l’anglais par notre équipe.

Plus d’un an s’est écoulé depuis que l’intelligence artificielle (IA) s’est largement répandue, modifiant, en particulier, radicalement les processus de prise de décision, les modes d’écriture, de pensée et d’analyse des modèles, entre autres. Depuis la sortie de logiciels tels que ChatGPT, l’utilisation de l’IA et ses applications ont été vivement débattues et discutées. Qu’il s’agisse de l’application de la loi, des soins de santé, de l’éducation ou des ressources humaines, l’utilisation (et dans certains cas, l’abus) de l’IA a suscité l’émoi de nombreux professionnels intéressés par ces questions. Dans mon propre domaine, celui des sciences de l’information, les publications d’articles, les ateliers numériques et les autres occasions d’apprendre, d’expérimenter et de discuter de cette technologie émergente et passionnante ne cessent de se multiplier.

L’ordinateur personnel est né bien plus tôt qu’on ne le pense

L'utilisation d'un ordinateur personnel est aujourd'hui une évidence. Il n'est plus nécessaire d'être un expert pour s'en servir, d'autant plus que ces appareils peuvent désormais prendre la forme d'un téléphone.

En fait, c’est dans l’État du New Hampshire aux États-Unis, précisément au Dartmouth College, le vrai nom de l’« Université de Dartmouth » tel qu’on le voit écrit dans la presse, que ce concept s’est matérialisé pour la première fois en 1964. Le Dartmouth College appartient à la Ivy Ligue qui rassemble huit universités prestigieuses du nord-est des États-Unis.

Ce concept fut l’aboutissement de la démarche de deux enseignants en mathématique dans cette université, John Kemeny et Thomas Kurz.

Ce dernier vient de décéder à l’âge de 96 ans, ce qui explique que ce sujet revienne dans l’actualité.

Quand la course à la publication menace la qualité scientifique : le cas Hindawi et la rétractation record de 2022

Dans un texte récent « Mesures et démesures de la publication scientifique », le mouvement « Ouvrir la science » attire l’attention sur l’augmentation très rapide , voire exponentielle, du nombre d’articles scientifiques publiés. Elle considère qu’elle n’est plus compatible avec le maintien de la qualité scientifique et la confiance dans les résultats obtenus par le minutieux travail de la relecture par les pairs.

Si les éditeurs « classiques » augmentent leur catalogue dans des proportions « raisonnables », ce billet cite trois éditeurs qui sont Frontiers, MDPI et Hindawi en remarquant la très forte croissance du nombre d’articles qu’ils publient. Cette forte croissance est liée, en particulier, à la publication de numéros spéciaux, notamment en 2022.

Retractation Watch signale, pour sa part, que Hindawi a retracté plus de 8 000 articles rien que pour l'année 2022, ce qui semble constituer un record. Wiley qui avait racheté cet éditeur en 2021 a décidé de ne plus utiliser la marque Hindawi et de ne garder que les quelques revues « irréprochables » de cet éditeur.

On notera que les auteurs des 8 000 articles retractés n’ont à peu près aucune chance de récupérer l’APC (article processing charge) qu’ils ont payé pour la publication de leur article.

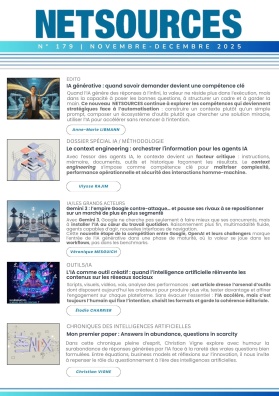

L’IA accélère, l’expert pilote : vers une nouvelle intelligence de la veille (édito)

Le dernier trimestre 2024 marque un tournant décisif dans l’évolution de nos métiers. L’émergence d’outils autonomes au potentiel disruptif met au défi de l’adaptation les pratiques éprouvées des professionnels de l’information et leur rôle d’intermédiation.

Ce numéro de NETSOURCES explore cette nouvelle étape à travers trois regards complémentaires.

Véronique Mesguich analyse comment OpenAI ne se contente pas de concurrencer Google avec SearchGPT, mais revisite l’expérience de recherche d’information (« SearchGPT vs Google AI vs Copilot : la bataille des géants pour réinventer la recherche web » Netsources N° 173 - dec 2024.

Cette génération d’outils, avec sa puissance de synthèse et la génération contextuelle de contenus, remet en question notre rapport même aux sources. En proposant des synthèses dont la traçabilité échappe souvent à notre contrôle, elle fragilise davantage la notion de référence aux sources, pilier de la recherche professionnelle déjà ébranlé par l’écosystème Internet. C’est la fiabilité même du travail informationnel qui est en jeu, au-delà des impacts sur le modèle économique des moteurs traditionnels et du système de référencement commercial.

Le décryptage que fait Ulysse Rajim sur l’avènement des agents IA révèle une autre dimension de cette transformation (« Repenser la veille à l’ère des agents IA » Netsources N° 173 - dec 2024). Ces systèmes semi-autonomes, capables de planifier et d’exécuter des séquences d’actions complexes, préfigurent l’avenir de nos outils professionnels. Leur capacité à combiner planification et exécution, même à un niveau d’autonomie encore modéré, annonce une transformation de nos méthodes de travail.

Enfin, les retours d’expérience du Forum de l’IES, analysés par Corinne Dupin, apportent un éclairage précieux sur ces évolutions. Les enseignements qui en émergent - de la contextualisation des demandes au contrôle continu des résultats — dessinent les contours d’une utilisation raisonnée de l’IAG et d’une nouvelle maturité dans notre approche des IAG (« Quand la vitesse et la puissance de calcul des IAG dépassent l’humain et invitent à réévaluer les pratiques de veille et d’intelligence économique » Netsources N° 173 - dec 2024).

Ces trois analyses convergent vers un constat commun : l’accélération technologique nous ramène paradoxalement aux fondamentaux de nos métiers. Le sens critique, la rigueur méthodologique et l’intelligence collective deviennent plus essentiels que jamais.

SearchGPT vs Google AI vs Copilot : la bataille des géants pour réinventer la recherche web

Annoncé l’été dernier par OpenAI sous forme de prototype, le moteur de recherche SearchGPT a été lancé en novembre pour les utilisateurs de la version premium et est depuis le 17 décembre accessible gratuitement à tous.

Au-delà d’un moteur de recherche classique, SearchGPT allie les capacités de génération de texte et de recherche contextuelle du modèle de langage d’OpenAI pour offrir une nouvelle expérience de la recherche d’informations.

OpenAI renforce ainsi sa concurrence directe non seulement avec des services de recherche basés sur l’IA comme Perplexity ou You.com, mais aussi avec les géants du Search en ligne que sont les moteurs Google ou Microsoft Bing Copilot. Doit-on en attendre une transformation radicale du paysage des outils de recherche ? Ou bien s’agit-il d’une tentative de la part d’OpenAI destinée à capter une part du marché lucratif de la recherche web, en « disruptant » le modèle économique ?

Google et Microsoft, de leur côté, innovent dans l’IA générative pour transformer l’expérience utilisateur dans leurs moteurs de recherche respectifs. Ces avancées permettront-elles de créer des outils adaptés à une large gamme d’utilisateurs, allant du « grand public » aux professionnels de la recherche, en répondant à leurs attentes spécifiques ? Comparons les stratégies de ces trois géants du numérique en matière d’outils de recherche web.

Repenser la veille à l’ère des agents IA

2024 marque un tournant dans l’histoire de l’intelligence artificielle : après les chatbots et les copilotes, une nouvelle génération d’outils fait son apparition - les agents IA. De Microsoft à Salesforce, en passant par Google et Anthropic, les géants de la tech investissent massivement dans ces systèmes capables de planifier et d’exécuter des séquences d’actions complexes. Dans cet article, nous explorerons ce nouveau développement dans le paysage de l’IA et ses impacts sur le métier de la veille.

Au-delà du chatbot

En 2023, après la sortie de ChatGPT quelques mois plus tôt, les chatbots s’imposaient comme la technologie phare de l’année. De Bing Chat à Claude, en passant par Gemini, les agents conversationnels étaient au centre de l’attention.

En 2024, ce sont les assistants IA (aussi appelés « copilotes ») qui font leur apparition, en s’inspirant de la fonctionnalité Github Copilot, elle-même mise à disposition du grand public en juin 2022. Plusieurs copilotes sont alors annoncés : Microsoft 365 Copilot, EinsteinGPT (Salesforce), Joule (SAP) ou encore Gemini (Google), pour en citer quelques-uns.

Après les récentes annonces de plusieurs Big Tech, il semblerait qu’en 2025 nous nous apprêtions à entrer dans l’ère des agents.

Quand la vitesse et la puissance de calcul des IAG dépassent l’humain et invitent à réévaluer les pratiques de veille et d’intelligence économique

L’IAG s’invite à l’IES (1) : plusieurs cas d’usage, quelques métriques et surtout une forte incitation à réévaluer les pratiques des acteurs de la veille et de l’IE à l’aune d’un outil qui va plus vite qu’eux à une échelle qui les dépasse.

Si l’intelligence artificielle truste les conversations, les salons et autres événements depuis l’avènement des IA génératives (IAG), le forum de l’IES ne fait pas exception et s’est largement fait l’écho des questionnements actuels sur leur intégration aux pratiques professionnelles. Pas moins de trois sessions plénières et une table ronde lui étaient consacrées.

L’intérêt des propos tenus sur le sujet à cette occasion réside dans leur inscription dans le quotidien de professionnels de la veille ou de l’IE dont la fonction rime avec l’expérimentation régulière de méthodes et outils à même de faciliter et dynamiser leur pratique. Plusieurs d’entre eux sont venus présenter des cas d’usage concrets des IAG et surtout quelques métriques (elles font cruellement défaut pour l’heure, le recul étant insuffisant sur une technologie somme toute encore assez jeune).

(1) L’IES est un événement organisé tous les deux ans par la Commission Intelligence Stratégique et Prospective de 3 AF (Association Aéronautique et Astronautique de France), qui réunit des acteurs de la veille et de l’intelligence économique de différents horizons (et pas seulement de l’industrie aéronautique). La dernière édition s’est tenue les 20 et 21 novembre dernier à Strasbourg.

14 000 articles retractés sur arXiv depuis 1991: WithdrarXiv les analyse

Un article très intéressant vient de paraître sur le site de preprint arXiv.

Il présente et analyse un ensemble de 14 000 articles publiés dans arXiv et rétractésdepuis l’origine d’arXiv en 1991 jusqu’à septembre 2024.

Ces articles rétractés sont accompagnés des commentaires liés à la rétractation. De plus, les auteurs ont classé les raisons des rétractations en 10 catégories :

- Factual/methodological/other critical errors in manuscript

- Incomplete exposition or more work in progress

- Typos in manuscript

- Self-identified as “not novel”

- Administrative or legal issues

- ArXiv policy violation

- Subsumed by another publication

- Plagiarism

- Personal reasons

- Reason not specified

Autre remarque intéressante : les rétractations sont relativement fréquentes dans le domaine médical, par contre, elles sont rares, voire absentes dans le domaine informatique.

Le zapping de François Libmann du 6/12/24 : Un nouveau guide sur les « repositories de confiance » et une base de données des deals immobiliers

Un nouveau guide sur les « repositories de confiance »

Ce nouveau guide propose une liste de « repositories de confiance dans différents domaines de recherche avec une évaluation de leur conformité avec les règles du Programme cadre Horizon Europe qui couvre, rappelons-le, la période 2021 à 2027.

Naviguer parmi les exigences concernant la science ouverte de l’ "Horizon Europe Model Grant Agreement" (MAGA) peut être difficile pour les chercheurs.

Le guide leur donne des recommandations pour sélectionner le(s) « repository/ies où déposer leurs résultats de recherche, en précisant que cela n’est pas un « liste blanche » ni une validation.

Cette démarche s’inscrit dans la promotion de la science ouverte et doit favoriser la collaboration entre chercheurs en Europe et plus largement.

La nouvelle édition du guide recense 241 « repositories » dont 186 ont été jugés dignes de confiance. La liste sous forme de tableau Excel avec de nombreux critères est accessible ici.

Parmi les mieux cotés, on signalera notre HAL national et l'Européen Zenodo.

Une base de données des deals immobiliers

CFNEWS IMMO publie en continu des informations très détaillées sur les deals immobiliers, essentiellement en France. Ces informations forment la matière première d’une base de deals qui regroupe plus de 6 500 opérations. La description de ces opérations est extrêmement détaillée, constituant autant de critères utilisables pour rechercher dans la base de deals.

Les deals immobiliers dont il est question ici sont exclusivement des deals professionnels. Une offre d’essai de huit jours est proposée pour se familiariser avec le site et le tester.

Les 20 ans de Google Scholar : un tournant ?

Google Scholar a été créé en 2004 par deux chercheurs. Son objectif a été et est toujours de référencer de grandes quantités d’articles, de rapports, de comptes-rendus de conférences, de livres ou de thèses pour peu qu’ils relèvent du secteur académique.

Sa devise « Standing on the shoulders of giants » signifie que Google Scholar existe parce que des chercheurs ont écrit et accumulé d’immenses quantités de connaissances. Cela a justifié la création de Google Scholar pour aider à naviguer dans cet océan d’information et y trouver des réponses à ses questions.

Google Scholar est beaucoup utilisé, et depuis longtemps, par un grand nombre de chercheurs

Les raisons de cette large utilisation sont très simples.

D’une part, l’accès est gratuit alors que de nombreuses sources d’information scientifique sont payantes. C’était particulièrement vrai il y a vingt ans, mais moins aujourd’hui.

D’autre part, l’étendue de sa couverture a pour conséquence qu’il est rare de ne pas trouver au moins quelques réponses intéressantes et bien souvent un nombre non négligeable à une question scientifique.

Enfin, son utilisation est simple, voire très simple, même si quelques possibilités avancées sont disponibles bien que pas toujours très mises en avant.

En revanche, la troncature n’existe pas alors que c’est un « must » pratiquement partout. On ne peut pas non plus entrer une chaîne de recherche experte sans même parler de combinaisons d’étapes totalement impossibles.

En ce qui concerne le traitement des réponses, leur nombre est limité à 1 000 ce qui est largement suffisant pour une simple lecture, mais ne l’est plus pour faire du data mining.

Aujourd’hui, Google Scholar est quelque peu sur la sellette.

Même si ses utilisateurs semblent être toujours aussi nombreux, on voit poindre une série de critiques plus ou moins fondamentales.