Les différents outils d’extraction de données

Les outils de scraping

Les outils de scraping, comme leur nom l’indique, permettent de récolter les informations d’un site Internet pour les classer dans un document exploitable. Ils sont utiles pour effectuer des benchmarks, des analyses de marché ou pour un usage personnel lorsqu’un grand nombre de chiffres sont à récupérer et organiser. On pourra par exemple récupérer simplement avec ces outils les prix de plusieurs biens immobiliers répartis sur plusieurs pages.

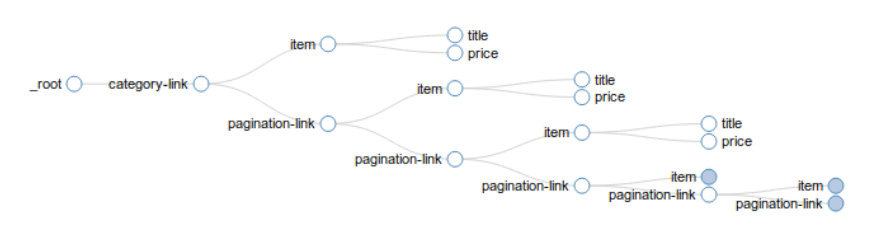

Les outils de scraping permettent d’extraire les informations contenues dans une page, et, plus globalement, dans un site web, en identifiant les « zones » et éléments récurrents composant ce site web. Ainsi, il faudra indiquer au scraper que l’on souhaite sélectionner systématiquement la « zone prix » d’une page à l’autre. Ces outils sont ensuite capables de crawler plusieurs pages web pour récupérer les données de même type.

Dans cette catégorie, on pourra citer des outils comme Data Scraper, Web Scraper Octoparse, Import.io ; Dexi.io ou encore ScrapingHub (voir figure 1.)

Logiciels OCR

On peut également faire appel à des outils OCR (Optical character recognition), technologie utilisée depuis de nombreuses années en bibliothèques pour numériser des ouvrages anciens. De plus en plus de petites applications ou logiciels OCR gratuits sont mis à disposition sur le Web et fonctionnent plutôt bien.

Par exemple, lors de recherches de tableaux concernant la croissance économique ou démographique d’un pays, il est intéressant de soumettre le document (au format PDF, jpeg, png, etc.) à un logiciel OCR pour être en mesure d’accéder aux chiffres. Ceci évite d’avoir à créer un tableau et de recopier manuellement les chiffres.

Un inconvénient notable de ces logiciels est leur difficulté à respecter l’ordre et la structure des mots et chiffres dans un document. Par exemple, lorsque vous soumettez une carte du monde au format jpeg avec des indications géographiques et un tableau contenant des chiffres, il se peut que le logiciel mélange les indications géographiques, et les place avant et/ou après les chiffres du tableau.

On pourra citer des outils comme LightPDF, SnagIT, ABBYY FineReader 15 ou encore Infrrd (voir figure 1.)

Figure 1. Panorama des outils de scraping

| Nom de l’outil | Usage | URL |

| Web scraper | ||

| Data Scraper (gratuit) | Extension Google Chrome - extraction donnée au format CSV ou XLS | https://huit.re/Data-Scraper-Chrome |

| Web Scraper (gratuit) | Extension Google - extraction donnée au format CSV à partir du plan de site | https://webscraper.io/ |

| Agenty (gratuit) | Add-on Chrome - extraction données «classes CCS» | https://huit.re/Agenty-Chrome-extension |

| Fminer (gratuit) | Logiciel extraction données d’une page web en XLS | http://www.fminer.com/ |

| ScrapeStorm (Freemium) | Logiciel de web scraping | https://www.scrapestorm.com/ |

| Octoparse (Freemium) | Logiciel extraction de données web - vers XLS | https://www.octoparse.com/ |

| WebHarvy (Freemium) | Web scrapping | https://www.webharvy.com/ |

| Import.io (Freemium) | Scrapping web import format CSV | https://www.import.io/ |

| Scrapy (gratuit) | Scrapping web - notions de code plus élaborées - outil collaboratif | https://scrapy.org/ |

| WebHose.io (payant - essai gratuit) | Scrapping/crawling web temps réel en 76 langues (news, blogs, reviews, dark web..) | https://webhose.io/ |

| Dexi.io (payant - essai gratuit) | Scrapping pages web en format CSV | https://www.dexi.io/ |

| ScrapingHub (payant - essai gratuit) | Outil scrapping web | https://scrapinghub.com/ |

| ParseHub (Freemium) | Scrapping web exploitable formats JSON, Excel and API | https://www.parsehub.com/ |

| 80legs (Freemium) | Web crawler + option scrapping téléchargement des données | http://80legs.com/ |

| OutWitHub (Freemium) | Extension Firefox - web crawler + scrapping formats CSV, HTML, Excel or SQL | https://www.outwit.com/products/hub/ |

| SimpleScraper (gratuit) | Extension Chrome scrapping sous format CSV ou JSON | https://simplescraper.io/ |

| Grepsr (payant) | Extraction de données web (une action de la part de Grepsr est nécessaire) | https://www.grepsr.com/ |

| Content Grabber (payant - essai gratuit) | Extraction données web | https://www.sequentum.com/cg-enterprise/ |

| Logiciels OCR | ||

| ABBYY FineReader 15 (payant - essai gratuit) | Logiciel d’analyse OCR des PDF pour toutes modifications | https://www.abbyy.com/en-eu/finereader/ |

| Infrrd (payant - essai gratuit) | Logiciel d’extraction de données financières, de facturation ou payement et documents divers | https://infrrd.ai/ |

| ProSuite (WordStat, QDA Miner, SimStat) par Provalis Research | Logiciels d’analyse de contenu, statistiques, et outil d’organisation/visualisation | https://provalisresearch.com/fr/produits/logiciels-analyse-semantique/ |

| LightPDF (gratuit) | Convertisseur en ligne de PDF ou images pour obtention de texte | https://lightpdf.com/fr/ocr |

| i2OCR (gratuit) | Convertisseur OCR en ligne | http://www.i2ocr.com/ |

| OCR.Space (gratuit) | Convertisseur OCR en ligne | https://ocr.space/ |

| SnagIT (payant - essai gratuit) | Logiciel de capture et enrichissement de texte à partir d’une image | https://www.techsmith.com/screen-capture.html |

| Outil extraction données PDF | ||

| Wondershare - Pdfelement (payant - essai gratuit) | Logiciel de conversion, modification, extraction données PDF | https://huit.re/Wondershare-PDFElement |

| Adobe Acrobat DC | Logiciel de traitement PDF | https://www.adobe.com/fr/ |

| Soda PDF (gratuit - version pro payante) | Logiciel de conversion + OCR PDF | https://www.sodapdf.com/ |

| Tabula (gratuit) | Sélection souris de la zone à extraire et conversion en CSV | https://tabula.technology/ |

| Docparser (payant - essai gratuit) | Logiciel d’extraction de données de fichiers PDF | https://docparser.com/ |

| Astera Software (payant - essai gratuit) | Logiciel d’extraction de données non structurées (PDF, DOCX, PRN, etc.) | https://huit.re/Astera |

| Mozenda (payant - essai gratuit) | Logiciel d’extraction de données non structurées (.csv, Network, Cloud, .xlsx, Web and API) | https://www.mozenda.com/data-wrangling-software/ |

Logiciels ad hoc et spécifiques PDF

Certains documents au format PDF ou sous certains formats particuliers (EPUB, TIFF, etc.) ne peuvent se convertir et se modifier en passant par les logiciels de web scraping ou OCR. De fait, il est nécessaire de mobiliser un logiciel spécifique pour extraire les informations utiles. Pour des raisons évidentes de trop grande abondance, nous n’avons pas recensé l’ensemble des logiciels ad hoc, mais plutôt quelques logiciels de traitement de documents PDF simples d’utilisation.

Parmi cette catégorie de logiciels, on peut citer des outils comme Adobe Acrobat DC, Tabula, Docparser, Mozenda ou encore Soda PDF (voir figure 1.)

Méthodes communes d’utilisation des outils de web scraping

À la différence des logiciels OCR, qui analysent l’ensemble d’un document, les web scraper nécessitent d’être paramétrés. Toutefois, il n’est pas besoin d’être développeur ou informaticien pour réussir à maîtriser la logique de ces outils.

Ils fonctionnent tous sur un principe similaire.

Sélection des informations

- La première chose à faire est de créer une nouvelle liste, une nouvelle sélection en renseignant le titre et le lien du site web visé. Certains outils demandent de catégoriser la nature de l’information que l’on veut sélectionner (lien, texte, image, HTML, etc.).

- Il est indispensable d’indiquer au logiciel quelle est la ou les zones à considérer.

Par exemple, imaginons que l’on souhaite compiler les prix affichés sur le site internet d’un concurrent. Pour ce faire, le web scraper décompose la page affichée en cases et boîtes distinctes, facilitant l’identification et la sélection des zones à retenir.

- Une fois la zone des prix sélectionnée, il faudra indiquer au web scraper qu’il doit retrouver et extraire la même case d’une page à une autre page similaire en cliquant sur l’onglet « page suivante » ou « next ».

Il est possible d’effectuer cette opération plusieurs fois afin de sélectionner toutes les informations à extraire en une seule fois.

Formalisation et extraction au format souhaité

- Indiquer au web scraper le nom de la zone sélectionnée revient à remplir les lignes et les colonnes du document final. Les lignes seront les éléments contenant les informations et les colonnes les cases indiquées. Ainsi, pour reprendre l’exemple des concurrents : les lignes seront remplies des noms des produits, et chaque colonne affichera le prix, la taille, le poids, etc.

- Une fois les sélections effectuées, il faudra indiquer à l’outil de commencer à réaliser l’extraction des informations. Cette opération peut prendre quelques secondes à quelques minutes selon le volume des informations à récupérer et le temps de réponse du site en question.

- Enfin, un aperçu du résultat sera proposé, qu’il est toujours bon de consulter avant d’effectuer son extraction. Certains outils proposent différents formats, les plus communs étant les formats CSV et XLS, pour obtenir des tableaux synthétiques et complets.

Astuces :

- Il est toujours préférable de choisir l’option de prévisualisation avant d’extraire les données pour s’assurer de l’exactitude des informations extraites (voir figure 2) ;

Figure 2. Prévisualisation dans l’outil de scraping

- Essayez les différentes possibilités du web scraper récemment installé sur ce site spécialement créé pour s’entraîner : http://example.webscraping.com/ ;

- Recherchez des tutoriels pour appréhender l’utilisation du web scraper que vous avez choisi ;

- Plus le site est structuré, plus il est aisé de configurer le web scraper et d’extraire les données.

Légalité du Web scraping ?

Il s’avère que la pratique du web scraping n’est pas illégale en soi, mais bien l’utilisation qui est faite des données ainsi recueillies. La commune acception est que le web scraping s’accapare rapidement et facilement un contenu qu’un tiers a plus difficilement produit et présenté. Le web scraping prend l’aspect d’un « parasitage » et d’une concurrence déloyale, en tirant profit des efforts qu’un tiers a fournis, au sens où l’entend le Code Civil (article 1240) et le Code de la consommation (article L.121-1). Le droit pénal français considère dans l’article 323-3 du Code pénal qu’extraire des données est puni de cinq ans d’emprisonnement et de 150 000€ d’amende.

Dans la pratique, il s’agit surtout de la réutilisation des données qui est répréhensible. La Justice juge finalement au cas par cas, selon la nature des informations « scrapées », le contexte du scraping et la nature des agents en cause (l’utilisation des données par une entreprise n’est pas celle faite par un individu à titre personnel).

Conclusion

Les outils d’extraction de données que nous avons abordés permettent de faire économiser un temps précieux et de s’assurer de l’exactitude des informations saisies lorsqu’il s’agit de recueillir un volume conséquent de données. Leur utilisation nécessite un temps restreint de formation, et peut se décliner dans les cadres professionnel et personnel. Il existe bien sûr des outils plus sophistiqués, mais dont l’utilisation est plus complexe et pour laquelle il faut mobiliser des connaissances en codage.