Un écosystème en transition : entre pillage massif, rééquilibrages juridiques et premiers modèles sous droits

L'IA générative ne se contente pas de « produire du texte ». Elle recompose le cadre même dans lequel l'information circule, est transformée et prend de la valeur.

Après quelques décennies d'un écosystème hybride, mêlant presse sous droits, bases professionnelles, web ouvert et intermédiation dominante de Google - un nouveau paysage se dessine, où des agents IA, encore largement alimentés par du scraping massif des contenus, souvent dénoncé comme une forme de captation non autorisée par les éditeurs, pourraient à terme fonctionner sur des corpus contractuels négociés.

Mais cette transition est loin d'être accomplie. Nous sommes dans un « entre-deux » instable où se côtoient pillage, litiges, opacité technique et premières tentatives de régulation. Les enjeux sont cruciaux pour les éditeurs, les professionnels de l'info-doc, les journalistes et, plus largement, l'ensemble des usagers.

-

Vous êtes ici :

- Accueil

- Tag : IA

Tag: IA

Pub Intermarché : pourquoi refuser l’IA a permis à la marque de signer l’une des pubs les plus marquantes ?

Alors que l’IA envahit de plus en plus le monde de la publicité, Intermarché a choisi de miser sur l’humain pour sa dernière campagne. Un défi qui a été un véritable carton !

À l’heure où l’intelligence artificielle s’impose dans de nombreuses créations publicitaires, Intermarché a fait un pari fou : celui de ne pas utiliser l’IA. Une campagne 100 % humaine ! Et le résultat a largement dépassé les attentes. Diffusée à l’approche des fêtes, la publicité mettant en scène un loup “mal aimé” a touché en plein cœur les internautes, au point de devenir virale bien au-delà des frontières françaises.

Dès sa mise en ligne, le film publicitaire a rencontré un engouement impressionnant. Sur les réseaux sociaux, il a dépassé les 31 millions de vues et récolté une avalanche de commentaires positifs. Un succès assumé et revendiqué par la marque. « C'est un carton mondial », s’est exclamé Thierry Cotillard sur Franceinfo, le patron des magasins Intermarché. Avant de préciser : « On a misé sur l’intelligence humaine et on en est hyper fiers. » Un message clair, qui résonne particulièrement dans un contexte où l’IA générative est de plus en plus critiquée, notamment pour son manque d’âme et d’authenticité.

Comment la publicité Intermarché a-t-elle séduit les spectateurs sans IA ?

Si cette publicité fonctionne autant, c’est avant tout grâce à son histoire. Intermarché n’a pas souhaité promouvoir ses produits. Son but ici est de raconter un conte, une fable moderne, qui parle autant aux enfants qu’aux adultes. Un loup qui n’arrive pas à se faire des amis et qui change son alimentation pour être accepté des autres, et trouver sa place à la table de Noël.

Peut-on tomber amoureux d’une IA ?

« Tomber amoureux d’une intelligence artificielle ». Il y a quelques années, cette phrase serait tout droit sortie d’un film de science-fiction ou d’un épisode de Black Mirror. Aujourd’hui, elle fait débat un peu partout : sur les réseaux sociaux, dans les médias, et même chez les psychologues. Avec l’arrivée des agents conversationnels ultra-réalistes, des applications de compagnons virtuels et des IA capables de simuler l’empathie, la question n’est plus si farfelue : peut-on réellement développer des sentiments amoureux pour une IA ?

Un Américain sur 5 a entretenu une relation amoureuse avec une IA

Eh bien, la réponse est oui. Aussi surprenant que cela puisse paraître, une récente étude du Massachusetts Institute of Technology a révélé qu’un Américain sur cinq a déjà entretenu une relation amoureuse ou sentimentale avec un chatbot IA, sur des plateformes comme Replika ou Character AI. Oui, vous avez bien lu. Au départ, il n’y avait aucune intention amoureuse, mais les sentiments ont finalement pris le dessus, malgré eux…

IA générative : les sources sous tensions

PubMed.ai n’est pas celui que l’on croit

Nous avons présenté dans le numéro 440 de BASES (octobre 2025) PubMed.ai et une série d’autres outils situés ou non dans l’écosystème de PubMed, proposant des recherches améliorées à base d’IA, de recherche sémantique ou d’autres outils.Notre présentation de PubMed.ai reposait sur une analyse précise de son utilisation et de ses fonctionnalités, tout en considérant l’appartenance manifeste de ce produit à l’écosystème PubMed, conformément aux informations obtenues via les informations collectées lors de la préparation de l’article. Cette évidence nous a conduits à ne pas approfondir davantage cet aspect.

À notre décharge, PubMed.ai utilisait la marque PubMed, s’appuyait sur les documents de PubMed et leur indexation (MeSH) pour élaborer les résultats.

Un lecteur de BASES particulièrement attentif nous a alertés, et nous l’en remercions vivement, sur le fait que PubMed.ai n’était pas lié à la NLM et que sa structure était très mystérieuse.

Cela nous a conduits à effectuer une série de recherches complémentaires et également à interroger plusieurs IA.

Reconnaissance faciale dans l’espace public: menace ou protection ?

Présentée comme un outil de sécurité, la reconnaissance faciale s’impose progressivement dans l’espace public. Mais entre protection des citoyens et atteinte aux libertés individuelles, le débat reste plus que jamais ouvert.

Que ce soit dans les rues, dans les gares, aux abords des écoles ou lors de grands événements… La vidéosurveillance fait désormais partie de notre quotidien. Mais depuis quelques années, une nouvelle technologie inquiète autant qu’elle intrigue : la reconnaissance faciale. Capable d’identifier une personne à partir de son visage, elle promet plus de sécurité, mais suscite aussi de nombreuses inquiétudes. Alors, faut-il y voir une avancée rassurante ou une menace pour nos libertés ?

La reconnaissance faciale repose sur un principe simple : analyser les traits du visage afin de les comparer à une base de données. En quelques secondes, un individu peut être reconnu. Contrairement aux caméras classiques, cette technologie ne se contente pas de filmer : elle identifie, trie et analyse. C’est précisément ce qui alimente les débats.

Un outil présenté comme une solution de sécurité : mais à quel prix ?

Ses défenseurs, notamment du côté des autorités, y voient un outil de prévention efficace : repérer une personne recherchée, sécuriser un rassemblement ou faciliter les enquêtes. Dans un contexte sécuritaire tendu, l’argument est souvent jugé rassurant.

Mais cette promesse soulève une crainte majeure : celle d’une surveillance généralisée. Être potentiellement identifié en permanence dans l’espace public, parfois sans le savoir, interroge notre droit à l’anonymat. À cela s’ajoute un autre point de vigilance : certains moteurs de recherche faciale sont aujourd’hui accessibles gratuitement sur le web et ouverts à tout public. La question des données personnelles se pose alors avec force : qui les collecte, où sont-elles stockées et pour combien de temps ?

Wikipédia et Grokipedia : la bataille du savoir à l’ère de l’IA

À l’heure où l’intelligence artificielle redéfinit l’accès au savoir, Wikipédia et Grokipedia, le nouveau projet d’Elon Musk, incarnent deux visions opposées : l’une communautaire et ouverte, l’autre centralisée et portée par xAI. Alors que Wikipédia adapte ses données pour dialoguer avec les IA tout en préservant sa transparence, Grokipedia promet une alternative « sans biais ».

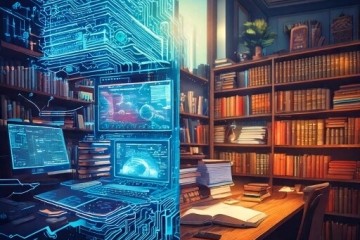

Le Wikidata Embedding Project : Wikipédia s’adapte à l’IA

Lancé le 1ᵉʳ octobre 2025 par la Wikimedia Foundation, en partenariat avec Jina.AI et DataStax, le Wikidata Embedding Project vise à rendre les 119 millions d’entrées de Wikidata, alimentées par 24 000 contributeurs actifs, exploitables par les intelligences artificielles.

Grâce à la recherche vectorielle, qui traduit les concepts en relations numériques via des modèles comme Jina Embeddings v3 (multilingue, jusqu’à 8 192 tokens), le système dépasse les recherches par mots-clés. Une requête sur « scientifique », comme l’illustre le site TechCrunch, proposera ainsi des biographies comme celles de Marie Curie ou Albert Einstein, des concepts liés comme la méthode scientifique ou des visuels tels que des schémas de formules.

Ce projet s’appuie sur des APIs vectorielles ouvertes, notamment celles de DataStax (Astra DB), pour intégrer les données de Wikidata dans les assistants IA via la technologie RAG (Retrieval Augmented Generation). Un webinar le 9 octobre 2025 a marqué le lancement, avec un support initial en anglais, français et arabe, et 30 millions d’entrées déjà vectorisées.

Maryana Iskander, PDG de la Wikimedia Foundation : "Face à l’IA, nous devons préserver notre modèle ouvert en l’intégrant intelligemment."

Cette stratégie répond à une urgence : les résumés IA de Google, déployés à grande échelle en 2025, captent 8 % du trafic humain de Wikipédia, menaçant ses dons, qui représentent 80 % de son financement.

De la RPA à l’IA générative : le parcours du service info de Deloitte France vers une gestion intelligente de l’information

Interview de Sylvie Sage, responsable du service d’information de Deloitte France. Interview menée par Christel RONSIN

Nous avons souhaité interroger Sylvie Sage afin de recueillir son témoignage sur la mise en place et l’utilisation de l’intelligence artificielle générative au sein d’un grand cabinet de conseil.

Sylvie Sage est responsable du Business Research Center (BRC) de Deloitte France depuis 17 ans. Elle est également impliquée au sein du Groupement Français de l’Industrie de l’Information (GFII) depuis 8 ans. Elle est co-animatrice du groupe de travail « Sourcing et analyse de l’information stratégique » du GFII.

CHRISTEL RONSIN : Sylvie, pouvez-vous nous expliquer dans quel contexte l’utilisation de l’intelligence artificielle générative est apparue au Business Research Center de Deloitte France ?

Comment une institution publique forme et sécurise ses équipes à l'ère de l'IA générative?

Interview menée par Christel Ronsin

Comment un établissement public encadre-t-il l’IA générative ? À l’EPSF, la question touche à la sécurité des données, à la gouvernance et à la formation des équipes. De la veille presse aux usages métier, jusqu’au rôle des documentalistes, cet interview explore les points clés d’une transformation encore en chantier.

Pauline Longin a été responsable du Centre de documentation de l’institut Polytechnique UniLaSalle à Beauvais durant plus de 4 ans et est responsable du service Documentation et Archives de l’EPSF depuis 2014. Elle intervient régulièrement aux évènements organisés par l’ADBS.

CHRISTEL RONSIN : Pauline, pouvez-vous décrire comment l’EPSF aborde l’intégration de l’Intelligence artificielle, notamment en termes d’outils et de sensibilisation des collaborateurs ?

PAULINE LONGIN : Le service Documentation et Archives, qui est rattaché à la DSI (Direction des Systèmes d’Information), a rapidement identifié des usages internes de l’IA, comme l’enregistrement de réunions via des applications par exemple. Cela a soulevé des questions de sécurité des données et cela a été le premier champ d’exploration de l’EPSF. Nous avons donc commencé par réfléchir à la mise à disposition d’une IA générative (IAG) grand public. Ces outils étant accessibles au public, les employés de l’EPSF étaient tentés de les utiliser dans leur environnement professionnel. Il a donc été essentiel de les mettre à disposition et de sensibiliser les collaborateurs.

IA générative : l’humain ne doit pas dire son dernier mot

Imaginez un monde où l’intelligence artificielle générative deviendrait un documentaliste chevronné pour orchestrer vos recherches les plus ardues, un allié incontournable dans toutes vos tâches de traitement et de gestion de l’information, un compagnon d’une humanité confondante sur les réseaux sociaux, - un monde où rédiger une lettre de motivation sans IA s’imposerait comme un acte d’authenticité revendiqué…

Ce monde est déjà le nôtre. À la lecture de ce Netsources, on mesure l’ampleur avec laquelle l’IAG s’est infiltrée dans chaque facette de nos activités intellectuelles .

Dans son « Guide pratique du Deep Research », Véronique Mesguich montre comment l’IA est particulièrement intéressante dans le cas de recherches complexes exigeant l’analyse de sources multiples, et de production de synthèses, redéfinissant — ce faisant — le rôle des experts.

Ulysse Rajim (« Quand l’IA réinvente les réseaux sociaux… ») décrypte comment l’IA redéfinit les interactions sur les réseaux sociaux, complexifie la veille en brouillant l’authenticité de la parole et convertit les plateformes en viviers de données pour nourrir leur apprentissage.

Trois métiers, une vision : Serda-Archimag face aux enjeux de l’IA générative

Interview de Louise Guerre, Co-Présidente du Groupe Serda-Archimag. Interview menée par Christel Ronsin

Nous avons souhaité interroger Louise Guerre afin de recueillir son témoignage sur la mise en place et l’utilisation de l’intelligence artificielle générative au sein d’une société spécialisée dans le management de l’information.

Louise Guerre est, avec Pierre Fuseau, dirigeante du groupe Serda-Archimag depuis sa création en 1985. Elle est également responsable mécénat et laboratoire des curiosités de l’association Étincelle, qui accompagne les jeunes décrocheurs. Avant cette date, Louise Guerre a présidé durant deux ans le Centre des Jeunes Dirigeants d’Entreprise (CJD), qui est le plus ancien mouvement patronal. Elle a également passé cinq ans au conseil d’administration d’Action contre la Faim.

CHRISTEL RONSIN : Louise, pouvez-vous nous expliquer comment l’intelligence artificielle générative (IAG) a été intégrée au sein du groupe Serda-Archimag ?

LOUISE GUERRE : Bien que l’Intelligence artificielle ait une histoire de plus de 50 ans, c’est avec l’arrivée des IAG en 2023 que nous avons observé un nouvel engouement pour cette technologie. J’ai alors immédiatement lancé un groupe de travail sur l'intelligence artificielle générative pour examiner son impact potentiel sur nos activités. En novembre 2023, ce groupe a réuni la rédactrice en chef d’ Archimag , Clémence Jost, un représentant de notre agence de communication éditoriale, ACE, un représentant de Serda Conseil et enfin un représentant de Serda Compétences. Ainsi tous les métiers étaient représentés. Comme nous le faisons habituellement, nous avons élaboré une note de cadrage, un PQP (Plan Qualité de Projet), et défini des livrables.

Nous avons rapidement identifié les opportunités fantastiques que les IAG pouvaient offrir, tout en mettant en lumière les craintes qu’elles pouvaient susciter parmi les professionnels de l’information, qui sont nos clients, ainsi que dans la société plus largement. Nous avons également évalué l’impact potentiel sur les divers métiers présents dans notre entreprise : les formateurs, les consultants, les journalistes, les rédacteurs, les commerciaux et le marketing.

Pour mieux comprendre ces enjeux, nous avons jugé essentiel de nous former. La formation est le meilleur moyen d’affiner nos craintes, d’y remédier si possible, et d’identifier les opportunités. Nous avons donc mis en place un vaste programme, adapté à chaque métier. Il est essentiel que le formateur soit un spécialiste du domaine, sinon la formation perd de sa pertinence.

L’évolution des IA conversationnelles : révolution de la recherche web, intégration professionnelle et personnalisation par la mémoire

Une nouvelle révolution de la recherche sur le Web ? Quand l’IA de Claude outille les développeurs pour réinventer la recherche web.

La mutation de la recherche Web traditionnelle sous l’impulsion de l’IA prend des formes multiples.

Cette mutation s’est traduite par une profusion d’innovations, qui illustrent la dynamique actuelle de l’IA appliquée à la recherche d’information :

● Les géants s’adaptent : Google et Bing, mais aussi des acteurs plus discrets comme you.com ou Brave, intègrent l’IA pour améliorer la pertinence de leurs résultats.

● L’essor de nouveaux moteurs : des outils « natifs IA » comme Perplexity AI, ou plus spécialisés comme Felo, Genspark et Andi, repoussent les limites de la recherche traditionnelle.

● Des extensions dopées à l’IA : Wiseone, Monica et d’autres facilitent l’accès à l’information directement dans votre navigateur.

● Les modèles de langage en action : OpenAI, Claude, Grok et leurs semblables embarquent des fonctions de recherche avancée (Deep Research) pour des réponses plus riches.

Mais un autre changement, moins visible et potentiellement plus disruptif, se dessine: les utilisateurs peuvent désormais personnaliser leur expérience de recherche selon leurs besoins spécifiques. On sort de la logique uniforme des moteurs de recherche traditionnels.

Quelles perspectives pour le veilleur à l'heure de pratiques prédatrices de son temps et de son discernement ?

L’avenir du métier de veilleur est assuré… pour peu qu’il joue à plein sa fonction d’éclaireur, garant du pluralisme et apôtre du temps long.

Récemment invitée à m’exprimer sur l’avenir du métier de veilleur devant une communauté de praticiens de la veille, je me suis souvenue d’avoir été sollicitée sur le même sujet il y a une dizaine d’années (1). Il faut croire que tous les 10 ans environ, une évolution technologique vient perturber le quotidien professionnel et la sérénité des veilleurs.

A l’époque, les préoccupations portaient sur les flux RSS (en passe de submerger le quotidien du veilleur et de l’aliéner au temps réel), la démocratisation de la curation (qui allait de pair avec la quête d’autonomie des usagers/clients), le règne de la conversation à l’heure des réseaux sociaux. Aujourd’hui, l’inquiétude est plutôt le fait de l’irruption des IA génératives avec l’avènement soudain, horizontal et gratuit, de ChatGPT.

Il y a 10 ans, je considérais déjà l’activité de veille comme une activité en mutation, qui s’orientait résolument vers l’accompagnement, le conseil, le transfert méthodologique. Il était de la même façon question de « destruction créatrice » (applicable aux usages comme aux métiers) promise par le numérique. Les réseaux sociaux sont toujours là, prêts sans désemparer à nous soumettre, si nous n’y prenons garde, à un régime d’alertes permanentes et à une réactivité maximale. La donne actuelle est complétée par la multiplication des contenus trompeurs (fake news, faux journaux scientifiques, revues et congrès prédateurs (2)…). Des conférences récentes, notamment à l’occasion de Documation, s’interrogent sur l’avenir des métiers de l’information, de l’intelligence économique et de la connaissance face à ces nouveaux défis et invitent à leur « réinvention » (quand la plupart des intervenants à la tribune ont préféré minimiser les efforts à produire en ne parlant que d’adaptation…).

IA Générative : état des lieux d’une course effrénée

L’intelligence artificielle générative évolue à une vitesse vertigineuse, rendant la prospective à long terme particulièrement ardue. Pourtant, une convergence de signaux faibles récents - avancées techniques, annonces des laboratoires d’IA, avis d’experts - suggère une nouvelle phase d’accélération. Une course mondiale s’est engagée entre les principaux acteurs, chacun cherchant à définir la prochaine frontière de l’IA.

Cet article propose un état des lieux de cette compétition intense, des avancées technologiques attendues dans les prochains mois, et explore leurs implications immédiates pour les professionnels de l’information.

Deep Research : l’âge de raison des IA ?

Depuis le début de l’année, les géants du numérique ont rivalisé d’annonces autour du Deep Research, ces nouveaux outils d’IA destinés à automatiser des recherches complexes sur le web. OpenAI, Google Gemini, Claude, DeepSeek, Perplexity et d’autres encore proposent désormais, parfois uniquement en version payante, de nouveaux modèles d’IA agentiques capables de mener en plusieurs étapes des recherches approfondies.

Dans le prochain numéro de Netsources, le sujet du Deep Research sera décliné sous un angle pratique.

Ces agents vont en effet composer le processus de recherche en plusieurs tâches automatisées : recherche de documents (pages HTML, images, documents PDF…), extraction et analyse des données pertinentes, puis production d’un rapport synthétique structuré mentionnant les sources utilisées.

Pour autant, ces agents automatisés sont-ils capables de détecter les sources les plus pertinentes, et d’en extraire les éléments utiles ? Quel sera l’impact de ces nouveaux agents sur les pratiques de recherches ? La profondeur d’analyse annoncée est-elle réelle ? Quelles sont leurs limites actuelles ? Commençons par nous pencher sur les modèles de raisonnement développés récemment, et qui sous-tendent ces nouveaux outils.

Google, moteur de transformation ? une évaluation de l’IA dans les produits numériques de Google

Ryan MULHOLAND est Research Librarian à l’Université Wesleyan du Tennessee aux États-Unis. L’article de Ryan a été traduit par notre équipe.Précisons que la fonctionnalité des Overviews décrite dans cet article n'est pas encore présente en France, même si elle l'est déjà dans certains pays d'Europe.

À nouvelle année, nouvelle série d’avancées dans le monde de l’intelligence artificielle. De la nouvelle capacité de génération d’images de ChatGPT avec la folie autour du style « Studio Ghibli », jusqu’à Grok qui déploie enfin sa propre application en version bêta, 2025 suscite déjà beaucoup d’effervescence autour de ces outils émergents.

Parmi les acteurs en lice, Google se démarque en intégrant des fonctionnalités d’assistance par IA à plusieurs de ses services gratuits, notamment Docs, Sheets, Slides, Maps, Search, Chrome et bien d’autres.

L’effervescence ne s’arrête pas là, car Google a déployé sa fonctionnalité Overviews (littéralement : « vue d’ensemble ») - aux États-Unis - le 14 mai de l’année dernière, puis Deep Research (« Recherche approfondie ») avec Gemini pour tous les utilisateurs le 13 mars de cette année. La première traite les requêtes complexes et tente de les résumer de manière facilement assimilable, tandis que la seconde permet aux utilisateurs de la version gratuite de générer trois rapports de recherche gratuits par jour pour une exploration plus poussée des sujets.

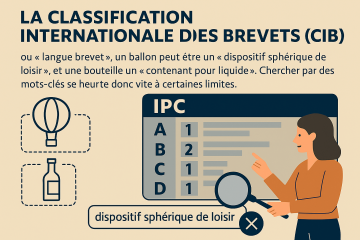

Avant que l’IA ne l’enterre, quelques mots sur la classification internationale des brevets

L’arrangement de Strasbourg, cela vous dit quelque chose ? On pourrait imaginer un quizz du type : c’est (1) le traité par lequel Louis XIV a réuni Strasbourg à la France le 30 septembre 1681 (2) un projet d’urbanisme de Catherine Trautmann lorsqu’elle était maire de Strasbourg (3) le texte qui a établi la classification internationale des brevets en 1971. Évidemment c’est la troisième réponse qui est la bonne. À l’heure où l’environnement médiatique est saturé par l’IA, nous allons, sans trop rentrer dans des détails théoriques, montrer par un simple exemple que cet outil de recherche conserve son intérêt, et qu’il reste même pour l’instant plus complémentaire qu’antagoniste avec les techniques basées sur l’IA. Le titre de cet article était donc seulement provocateur.

Un bref rappel

La Classification Internationale des Brevets (abrégé CIB) ou, en anglais, International Patent Classification (IPC) a été mise en place pour répondre au défi de rechercher des documents au sein d’une masse croissante de brevets, dans un contexte caractérisé par le multilinguisme, et une syntaxe, qui outre les problématiques habituelles de synonymie, peut être très déconcertante : en « langue brevet », un ballon peut être un « dispositif sphérique de loisir », et une bouteille un « contenant pour liquide ». Chercher par des mots-clés se heurte donc vite à certaines limites.

IA : Google, xAI et Anthropic dévoilent chacun le modèle le plus intelligent du moment

Google : des mises à jour majeures pour ses modèles Gemini, Gemma, sans oublier Gemini Live

Il est difficile de suivre ce qui se passe dans la Galaxie IA Google, tant les annonces de fonctionnalités et projets sont nombreuses.

La stratégie de la division IA Google DeepMind s’articule autour de deux modèles : Gemini et Gemma (hors développements spécifiques image et vidéo). Gemini est un modèle ultra puissant, mais fermé, utilisé à la fois pour les services grand public tels que le Search et pour les applications professionnelles ; à l’opposé, Gemma est un système beaucoup moins gourmand en ressources, en open-source, conçu pour la communauté des développeurs.

Quand l’IA invisibilise les sources : vers une ère sans données de référence ?

Deux ans après l’irruption fulgurante de l’IA générative dans nos vies, peut-on craindre une réécriture ou un effacement progressif de nos savoirs fondamentaux ?

Le paysage est contrasté. D’un côté, des avancées technologiques spectaculaires - notamment en santé ou en traduction automatique. De l’autre, une remise en question profonde de nos méthodes traditionnelles d’accès à la connaissance, d’analyse critique et de validation. À la clé, un risque réel : perdre pied dans un écosystème informationnel où la traçabilité devient optionnelle.

Le salon I-Expo/Documation, qui vient de tenir sa session annuelle, offrait un reflet saisissant de cette dualité. L’affluence remarquable aux conférences centrées sur l’IA témoignait d’un intérêt évident et d’une volonté de comprendre le phénomène dans son ensemble. Mais elle allait de pair avec une inquiétude et une prise de conscience : la nécessité d’encadrer ces outils et de préserver nos repères humains ainsi que l’accès à une information sourcée, fiable et compréhensible.

Particulièrement révélateurs à cet égard étaient les discours des éditeurs de logiciels de veille. D’un côté, ils valorisaient l’intégration des fonctionnalités d’IAG dans leurs plateformes, notamment pour la traduction, le résumé, l’analyse, avec même parfois un package de prompt engineering pour faciliter les interactions du veilleur avec le modèle d’IA. Parallèlement, ils réaffirmaient leur engagement à maintenir le rôle primordial des experts et de l’intelligence humaine dans l’analyse stratégique au service de la prise de décision, et mettaient en garde contre la « boîte noire » de l’IAG.

Des ondes sonores aux résumés : l'analyse des podcasts par l'IA change la donne

Dans le paysage en constante expansion des podcasts, où des millions d’heures de contenu sont produites quotidiennement, une nouvelle frontière émerge. L’intelligence artificielle (IA), autrefois réservée à la science-fiction, révolutionne aujourd’hui la façon dont nous consommons le contenu audio. L’IA est entrée dans l’arène, offrant une solution révolutionnaire qui transforme le son brut en transcriptions et en résumés avec rapidité et précision.

Ce saut technologique n’est pas seulement une question de commodité, il remodèle tout le paysage de l’accessibilité des podcasts. Qu’il s’agisse de professionnels très occupés cherchant à obtenir rapidement les éléments importants ou de chercheurs réalisant du data mining, la capacité de l’IA à distiller des heures de conversation en extraits digestes est tout simplement incroyable.

Mais à quel point l’IA est-elle efficace dans cette tâche ?

Traduit de l’anglais par l’équipe de BASES PUBLICATIONS

Orbit Intelligence propose de nouveaux outils dopés à l’IA

L’IA étant devenue incontournable, la plupart des serveurs et agrégateurs de presse développent de nouveaux outils ou de nouvelles interfaces intégrant ces développements technologiques.

Les équipes de Questel sont persuadées que l’IA va profondément bouleverser les opérations liées à la propriété intellectuelle, aussi bien pour la recherche, que la visualisation des résultats puis de leur analyse, le classement des résultats et plus généralement pour optimiser les workflows complexes de ce domaine.

Nous avons déjà présenté dans ces colonnes SCOPUS AI et Web of Science Research Assistant (BASES, Nos 425 et 428). Nous explorons aujourd’hui les améliorations apportées par Questel à Orbit Intelligence par l’utilisation de ChatGPT tant pour la recherche que pour la visualisation des réponses.

L’IA peut-elle écrire à notre place ? le test des « styles » de Claude

Nous avions décrit dans la rubrique IA du dernier numéro de BASES comment utiliser la nouvelle fonctionnalité « styles rédactionnels » de Claude, dont la promesse est de produire un texte avec le « bon style de rédaction ».

Cette fonctionnalité est intéressante en soi, car elle nous emmène déjà au-delà de la « simple » génération de contenus, vers la création de textes toujours plus personnalisables, de qualité comparable à ceux que l’on produit manuellement et même, pourrait-on dire, « humanisés ».

Claude fait d’une certaine façon « coup double » avec cette fonctionnalité des styles personnalisés : elle concerne à la fois la rédaction d’un texte en imitant un auteur humain donné et l’adaptation du message au type de public cible.

L’IA accélère, l’expert pilote : vers une nouvelle intelligence de la veille (édito)

Le dernier trimestre 2024 marque un tournant décisif dans l’évolution de nos métiers. L’émergence d’outils autonomes au potentiel disruptif met au défi de l’adaptation les pratiques éprouvées des professionnels de l’information et leur rôle d’intermédiation.

Ce numéro de NETSOURCES explore cette nouvelle étape à travers trois regards complémentaires.

Véronique Mesguich analyse comment OpenAI ne se contente pas de concurrencer Google avec SearchGPT, mais revisite l’expérience de recherche d’information (« SearchGPT vs Google AI vs Copilot : la bataille des géants pour réinventer la recherche web » Netsources N° 173 - dec 2024.

Cette génération d’outils, avec sa puissance de synthèse et la génération contextuelle de contenus, remet en question notre rapport même aux sources. En proposant des synthèses dont la traçabilité échappe souvent à notre contrôle, elle fragilise davantage la notion de référence aux sources, pilier de la recherche professionnelle déjà ébranlé par l’écosystème Internet. C’est la fiabilité même du travail informationnel qui est en jeu, au-delà des impacts sur le modèle économique des moteurs traditionnels et du système de référencement commercial.

Le décryptage que fait Ulysse Rajim sur l’avènement des agents IA révèle une autre dimension de cette transformation (« Repenser la veille à l’ère des agents IA » Netsources N° 173 - dec 2024). Ces systèmes semi-autonomes, capables de planifier et d’exécuter des séquences d’actions complexes, préfigurent l’avenir de nos outils professionnels. Leur capacité à combiner planification et exécution, même à un niveau d’autonomie encore modéré, annonce une transformation de nos méthodes de travail.

Enfin, les retours d’expérience du Forum de l’IES, analysés par Corinne Dupin, apportent un éclairage précieux sur ces évolutions. Les enseignements qui en émergent - de la contextualisation des demandes au contrôle continu des résultats — dessinent les contours d’une utilisation raisonnée de l’IAG et d’une nouvelle maturité dans notre approche des IAG (« Quand la vitesse et la puissance de calcul des IAG dépassent l’humain et invitent à réévaluer les pratiques de veille et d’intelligence économique » Netsources N° 173 - dec 2024).

Ces trois analyses convergent vers un constat commun : l’accélération technologique nous ramène paradoxalement aux fondamentaux de nos métiers. Le sens critique, la rigueur méthodologique et l’intelligence collective deviennent plus essentiels que jamais.

SearchGPT vs Google AI vs Copilot : la bataille des géants pour réinventer la recherche web

Annoncé l’été dernier par OpenAI sous forme de prototype, le moteur de recherche SearchGPT a été lancé en novembre pour les utilisateurs de la version premium et est depuis le 17 décembre accessible gratuitement à tous.

Au-delà d’un moteur de recherche classique, SearchGPT allie les capacités de génération de texte et de recherche contextuelle du modèle de langage d’OpenAI pour offrir une nouvelle expérience de la recherche d’informations.

OpenAI renforce ainsi sa concurrence directe non seulement avec des services de recherche basés sur l’IA comme Perplexity ou You.com, mais aussi avec les géants du Search en ligne que sont les moteurs Google ou Microsoft Bing Copilot. Doit-on en attendre une transformation radicale du paysage des outils de recherche ? Ou bien s’agit-il d’une tentative de la part d’OpenAI destinée à capter une part du marché lucratif de la recherche web, en « disruptant » le modèle économique ?

Google et Microsoft, de leur côté, innovent dans l’IA générative pour transformer l’expérience utilisateur dans leurs moteurs de recherche respectifs. Ces avancées permettront-elles de créer des outils adaptés à une large gamme d’utilisateurs, allant du « grand public » aux professionnels de la recherche, en répondant à leurs attentes spécifiques ? Comparons les stratégies de ces trois géants du numérique en matière d’outils de recherche web.

Repenser la veille à l’ère des agents IA

2024 marque un tournant dans l’histoire de l’intelligence artificielle : après les chatbots et les copilotes, une nouvelle génération d’outils fait son apparition - les agents IA. De Microsoft à Salesforce, en passant par Google et Anthropic, les géants de la tech investissent massivement dans ces systèmes capables de planifier et d’exécuter des séquences d’actions complexes. Dans cet article, nous explorerons ce nouveau développement dans le paysage de l’IA et ses impacts sur le métier de la veille.

Au-delà du chatbot

En 2023, après la sortie de ChatGPT quelques mois plus tôt, les chatbots s’imposaient comme la technologie phare de l’année. De Bing Chat à Claude, en passant par Gemini, les agents conversationnels étaient au centre de l’attention.

En 2024, ce sont les assistants IA (aussi appelés « copilotes ») qui font leur apparition, en s’inspirant de la fonctionnalité Github Copilot, elle-même mise à disposition du grand public en juin 2022. Plusieurs copilotes sont alors annoncés : Microsoft 365 Copilot, EinsteinGPT (Salesforce), Joule (SAP) ou encore Gemini (Google), pour en citer quelques-uns.

Après les récentes annonces de plusieurs Big Tech, il semblerait qu’en 2025 nous nous apprêtions à entrer dans l’ère des agents.

Quand la vitesse et la puissance de calcul des IAG dépassent l’humain et invitent à réévaluer les pratiques de veille et d’intelligence économique

L’IAG s’invite à l’IES (1) : plusieurs cas d’usage, quelques métriques et surtout une forte incitation à réévaluer les pratiques des acteurs de la veille et de l’IE à l’aune d’un outil qui va plus vite qu’eux à une échelle qui les dépasse.

Si l’intelligence artificielle truste les conversations, les salons et autres événements depuis l’avènement des IA génératives (IAG), le forum de l’IES ne fait pas exception et s’est largement fait l’écho des questionnements actuels sur leur intégration aux pratiques professionnelles. Pas moins de trois sessions plénières et une table ronde lui étaient consacrées.

L’intérêt des propos tenus sur le sujet à cette occasion réside dans leur inscription dans le quotidien de professionnels de la veille ou de l’IE dont la fonction rime avec l’expérimentation régulière de méthodes et outils à même de faciliter et dynamiser leur pratique. Plusieurs d’entre eux sont venus présenter des cas d’usage concrets des IAG et surtout quelques métriques (elles font cruellement défaut pour l’heure, le recul étant insuffisant sur une technologie somme toute encore assez jeune).

(1) L’IES est un événement organisé tous les deux ans par la Commission Intelligence Stratégique et Prospective de 3 AF (Association Aéronautique et Astronautique de France), qui réunit des acteurs de la veille et de l’intelligence économique de différents horizons (et pas seulement de l’industrie aéronautique). La dernière édition s’est tenue les 20 et 21 novembre dernier à Strasbourg.

L'IA Act pour la veille et l'IE : naviguer entre marécage et certitudes

Maître Thibault du Manoir de Juaye, avocat à la Cour de Paris, est un spécialiste reconnu en intelligence économique et en droit de la sécurité privée. Il a fondé son cabinet en 1995, intervenant régulièrement sur des dossiers liés à l’intelligence économique, notamment en matière de propriété intellectuelle.

Auteur de plusieurs ouvrages sur le sujet, il a également été rédacteur en chef du magazine « Regards sur l’IE ».

L’intelligence artificielle amplifie les problématiques juridiques déjà connues pour la veille et l’IE, notamment en raison de sa faculté à faciliter les recherches et à générer automatiquement des contenus de tout type.

Même si elle n’en est sans doute qu’à ses débuts, il existe déjà des tentatives pour encadrer juridiquement l’intelligence artificielle (IA).

Des juristes imaginatifs (et pour moi loufoques) vont même jusqu’à soutenir qu’il faudrait donner la personnalité juridique aux systèmes d’IA, un peu comme les sociétés ont la personnalité morale. Mais il ne s’agit pour le moment que de spéculations ludiques et récréatives, sans grand intérêt, sauf pour quêter une exposition médiatique à moindres frais.

Il faut donc s’en tenir au droit positif.

L’intelligence artificielle est désormais encadrée par un règlement européen en date du 12 juillet 2024, texte qui sera complété par des milliers de pages d’application.

L'IA transforme le monde professionnel : gains de productivité et éthique

Devant l’avalanche d’annonces sur les innovations et nouveautés en IA, cette rubrique met en avant celles que nous considérons comme utiles pour les professionnels de l’information.

N’hésitez pas à nous partager vos questions ou sujets d’intérêt liés à l’IA en nous écrivant à l’adresse Cette adresse e-mail est protégée contre les robots spammeurs. Vous devez activer le JavaScript pour la visualiser..

En préliminaire, il nous paraît important de clarifier notre position sur la difficulté à recommander de s’abonner à tel ou tel modèle d’IA pour accéder à certaines fonctionnalités (même si nous pensons que l’abonnement à ChatGPT est un must).

La dynamique entre les fonctionnalités gratuites et payantes dans les modèles d’IA évolue constamment, en fonction des stratégies commerciales, des retours utilisateurs et des innovations technologiques. Une fonctionnalité peut être d’abord réservée aux abonnés puis devenir gratuite, ou inversement, être monétisée après avoir gagné en popularité.

Visual PDFs : la révolution de Claude dans l’analyse documentaire

Anthropic sort une nouvelle version de son modèle Claude 3.5 Sonnet avec une innovation majeure dans le traitement documentaire, qui enrichit l’analyse les documents complexes en extrayant et analysant les éléments visuels contenus quand il existent.

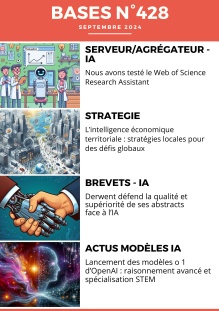

Nous avons testé le Web of Science Research Assistant

Après neuf mois de tests auprès de la communauté des utilisateurs de Web of Science, Clarivate vient d’annoncer le lancement de son assistant de recherche dopé à l’IA pour la recherche sur le contenu de Web of Science Core qui propose 92 millions de références dans le domaine scientifique depuis le début du 20° siècle.

Nous avons testé ce nouvel outil qui illustre l’investissement des serveurs et agrégateurs dans des possibilités de recherche nouvelles sur leur fonds grâce à l’intelligence artificielle.

Interface et options de recherche

L’écran d’accueil est commun avec la recherche classique sur le Web of Science. L’accès se fait par un clic sur « Search assistant » qui donne accès à la nouvelle interface. On se voit alors proposer quatre options qui correspondent à autant de problématiques.

La première baptisée « Start a new search by asking a question » permet de lancer une question spécifique en langage naturel. « C’est une méthode intuitive pour commencer une exploration, particulièrement utile pour les chercheurs qui ne sont pas familiers avec les techniques de recherche avancées. »

La seconde, « Understand a topic » a pour objectif d’offrir rapidement une vue d’ensemble structurée d’un sujet spécifique. C’est un excellent point de départ pour se familiariser rapidement avec un nouveau domaine de recherche ».

Derwent défend la qualité et supériorité de ses abstracts face à l’IA

DERWENT qui réécrit les titres et les abstracts de brevets depuis des dizaines d’années affirme que sa pratique est plus performante qu’une utilisation d’une IA.

La banque de données DWPI (Derwent World Patents Index) commercialisée aujourd’hui par Clarivate a été créée il y a plus de 60 ans et a une grande notoriété auprès des spécialistes de la recherche d’information brevet.

DWPI a longtemps été la principale source utilisée par les professionnels.

Sa valeur ajoutée tient en plusieurs points :

• La réécriture par des experts (aujourd’hui au nombre de 900) du titre et du résumé pour les rendre plus clairs et plus informatifs alors que la tendance des déposants est justement d’être le moins compréhensible ou le plus général possible ;

• L’extraction et la présentation des informations concernant la nouveauté, les avantages, l’usage ainsi qu’un focus technologique ;

• L’attribution des codes de classifications spécifiques en plus des classifications classiques (CIB et CPC) ;

• Une vérification, avec éventuellement des compléments, concernant les données bibliographiques.

L’IA accélère la transformation de la veille et de la recherche d’information

On pressent que la « révolution IA générative » va à terme jouer un rôle central dans la redéfinition des pratiques de veille stratégique et technologique. Dans ce nouveau Netsources, nous vous emmenons au cœur de cette métamorphose naissante.

Deux des experts reconnus de la veille en France, Mathieu Andro et Corinne Dupin, ont mené une nouvelle étude du marché des plateformes de veille, Netsources N° 171 - juillet/août 2024. Nous sommes heureux d’ouvrir ce numéro avec leur analyse approfondie de l’enquête 2024. Leur étude révèle l’intégration croissante de l’IA dans ces systèmes, qui laisse présager une refonte en profondeur du modèle traditionnel du cycle de la veille.

La révolution de l’IA s’étend également au champ cognitif, démocratisant l’accès à la connaissance. Par exemple, dans le domaine scientifique, Aurélie Vathonne démontre comment de nouveaux outils dopés à l’IA permettent désormais à des veilleurs généralistes de s’immerger dans des domaines complexes, brisant ainsi les barrières d’entrée au savoir scientifique (« Comment se saisir avec pertinence de l’information scientifique lorsqu’on n’est pas scientifique ? », Netsources N° 171 - juillet/août 2024).

Par ailleurs, l’article « Perplexity, le couteau suisse de la découverte d’informations et de la curiosité », Netsources N° 171 - juillet/août 2024, analyse l’évolution de ce moteur de réponses hybride, combinant les forces d’un moteur de recherche traditionnel et d’un agent conversationnel. Perplexity incarne cette nouvelle génération d’outils visant à réduire l’incertitude et à fournir des réponses claires, tout en suscitant des débats éthiques sur l’utilisation des sources et la propriété intellectuelle.

Enfin, nous aborderons une question rarement traitée, mais présente dans tous les esprits : «Faut-il optimiser ses prompts en fonction de chaque modèle d’IA ?». Cette interrogation souligne notre prise de conscience des enjeux liés à la personnalisation de nos interactions avec les modèles d’IA, afin d’en tirer le meilleur parti. Nous verrons également comment l’IA offre au veilleur/analyste généraliste de nouvelles perspectives en termes d’immersion dans des champs de connaissance qui lui étaient jusque-là inaccessibles.

Rappelons quand même que l’IA générative, même nourrie des meilleurs prompts et d’investissement personnel, reste un outil qui amplifie l’expertise humaine plutôt qu’un substitut à la réflexion critique et à l’expertise métier.

Les Tags de Bases

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- moteurs académiques

- revues académiques

- sourcing veille

- flux RSS

- professionnel de l'information

- dirigeant

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- agenda

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- biomédical

- Questel

- Dialog

- références bibliographiques

- thèses

- résumé automatique

- Bing

- open citation

- Scopus

- veille collaborative

- outsourcing

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- Corée du Sud

- Pressedd

- LexisNexis

- Newsdesk

- sourcing pays

- chimie

- e-réputation

- recherche publique

- droit d'auteur

- littérature grise

- archives ouvertes

- veille medias

- dark web

- veille commerciale

- trésor du web

- réseaux sociaux

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- Bluesky

- podcast

- dark social

- shadow social

- science ouverte

- open source

- veille technologique

- knowledge management

- littérature scientifique

- web of science

- derwent

- abstracts

- protocole

- Intelligence artificielle

- OpenAI

- Commerce conversationnel

- GEO

- veille automatisée

- agents conversationnels

- recherche biomédicale

- veille informationnelle

- Afrique

- copyright